iBet uBet web content aggregator. Adding the entire web to your favor.

Link to original content: http://www.infobidouille.com/atom.xml

Sous ce nom se cache un clavier visuellement quasi identique au clavier officiel pour Raspberry Pi proposé depuis des années par la fondation, mais cette fois il ne s’agit pas d’un périphérique, mais bien d’un ordinateur complet : le clavier intègre tous les composants du Pi 4, montés sur une nouvelle carte mère toute en longueur, pour intégrer tous les ports sur l’arrière du clavier (à l’exception d’un des deux ports USB 2.0, qui disparait dans l’opération, sans doute par manque de place).

La fondation a même profité de l’occasion pour améliorer encore son ordinateur à bas prix, puisque les quatre cœurs ARM Cortex-A72 qui l’animent moulinent désormais à 1.8 GHz contre seulement 1.5 GHz sur le Pi 4, dont on espère qu’il pourra lui aussi bénéficier à court terme de ce SoC légèrement boosté. Il faudra par contre se contenter d’une unique configuration à 4 Go de RAM, alors que le Pi 4 est proposé avec au choix 4 ou 8 Go.

En France, ce nouveau modèle est comme d’habitude distribué par Kubii, qui le propose à 74€50 en version nue et 106€50 pour un kit complet, contenant en plus du Pi 400 AZERTY une alimentation secteur, une souris filaire, un câble HDMI, une microSD de 16 Go avec Raspberry Pi OS préinstallé et le guide officiel Raspberry Pi, désormais traduit en français.

]]>

Avec cette transition, la troisième dans l’histoire d’Apple, c’est une page majeure de l’histoire du Mac qui se tourne. Le passage aux processeurs x86 avait en effet sans aucun doute contribué au renouveau du Mac pendant les quinze dernières années, notamment en faisant des Mac des machines « idéales » pour les développeurs, capables de faire tourner indifféremment les trois systèmes d’exploitation majeurs, macOS bien sûr, mais aussi Windows et quasiment toutes les distributions Linux, le tout avec un bond de performances majeur par rapport aux anciennes machines, dont les CPU PowerPC étaient à bout de souffle.

Avec cette transition, la troisième dans l’histoire d’Apple, c’est une page majeure de l’histoire du Mac qui se tourne. Le passage aux processeurs x86 avait en effet sans aucun doute contribué au renouveau du Mac pendant les quinze dernières années, notamment en faisant des Mac des machines « idéales » pour les développeurs, capables de faire tourner indifféremment les trois systèmes d’exploitation majeurs, macOS bien sûr, mais aussi Windows et quasiment toutes les distributions Linux, le tout avec un bond de performances majeur par rapport aux anciennes machines, dont les CPU PowerPC étaient à bout de souffle.

Cette nouvelle transition me laisse personnellement bien plus circonspect, moi qui ai abandonné le Mac il y a quelques années déjà, déçu de l’orientation prise par Apple, vers toujours plus de fermeture. Clairement, ces nouvelles machines vont en quelques sorte exacerber les qualités et les défauts des Mac actuels. L’intégration poussée, puisque les Mac vont désormais être doté d’un SoC avec CPU et GPU intégrés, va sans doute permettre d’améliorer encore la compacité et l’optimisation de la consommation, pour maximiser l’autonomie des machines portables. La maitrise totale du matériel par Apple, qui va donc désormais développer le processeur, la puce graphique, le circuit audio, le contrôleur de stockage, le circuit d’acquisition vidéo, les circuits d’encodage/décodage vidéo, pourrait aider également la firme d’optimiser au mieux la couche logicielle, en ne dépendant plus de tiers. Apple devient ainsi indépendante d’Intel, mais aussi d’AMD et nVidia notamment.

Mais ce sera au prix d’une fermeture elle aussi encore plus poussée. Sur le plan matériel, on peut s’attendre à ce qu’il n’y ait vraiment plus aucun composant modifiable sur une large partie de la gamme. Et il ne faudra bien entendu plus compter sur les hackintosh pour compenser ça… Sur le plan logiciel, là encore, on s’oriente vraisemblablement vers un macOS de plus en plus restrictif, avec la convergence progressive entre iOS et macOS. La nouvelle version de macOS acte d’ailleurs cette convergence sur le plan de la présentation, toujours plus proche de celle d’iOS, et il sera désormais possible d’exécuter des applications iOS sur les Mac ARM. S’il n’est pas prévu pour l’instant de bloquer les applications ne provenant pas du Mac App Store, on peut toutefois s’attendre à ce qu’Apple pousse toujours plus vers cette solution. Et bien sûr, ce passage aux puces ARM marque la fin de la possibilité d’exécuter nativement Windows et sa large logithèque sur Mac.

Pour faciliter la transition, Apple va intégrer à macOS un module Rosetta 2 qui assurera la traduction des applications Mac x86 en applications Mac ARM, tandis que la nouvelle version de Xcode permettra de compiler des « fat binaries » compatibles avec les deux architectures. Des solutions qui avaient déjà été mises en place lors de la transition précédente, la facilitant grandement.

Apple a aussi pensé aux adeptes de Linux, et proposera nativement des outils permettant de faciliter la virtualisation de distributions Linux ARM sous macOS. Rien n’a été dit par contre à propos de Windows. Bien que celui ci soit disponible en version ARM depuis quelques années, cette version n’a jusqu’à présent été distribuées que via préinstallation sur des machines, et il y a donc peu de chances de voir à court terme une version Mac de Windows 10 ARM. Sa disponibilité éventuelle dépendra sans doute du succès de ces nouveaux Mac.

Car c’est bien là la grosse inconnue (au delà des performances, passées sous silence pour l’instant, mais qu’il est peu pertinent d’évoquer à un an de la sortie des premières machines), sur laquelle j’aurais bien du mal à me prononcer aujourd’hui : quel va être l’accueil pour ces machines auprès des clients d’Apple ? Il est indéniable que pour certains, cette transition va être une régression, qui pourrait les pousser à quitter le navire. Je pense notamment à bon nombre de développeurs qui appréciaient les Mac pour leur compatibilité avec « tous » les OS et leur côté très pratique pour travailler avec certains outils comme Docker, et à qui Microsoft fait des appels du pied depuis quelques temps, avec le développement de WSL.

Mais pour d’autres, cette transition pourrait au contraire rendre le Mac encore plus attractif. Le grand public se préoccupe en effet assez peu de l’ouverture, de la réparabilité, mais bien plus du design et de l’autonomie… Voire même du prix, puisque cette intégration plus poussée pourrait permettre à Apple de réduire grandement ses coûts de production, et ainsi de vendre des Mac moins cher sans pour autant sacrifier la sacro-sainte marge. Quand aux performances, même si ces nouvelles puces ne feront pas forcément mieux que les puces Intel, en particulier les plus gros modèles, il ne faut pas oublier que la plupart des usages d’aujourd’hui peuvent être accomplis avec des puces relativement modeste. Le succès des Chromebooks le prouve.

Rendez-vous donc dans quelques années pour faire le bilan de cette transition et voir si avec elle le Mac aura connu un nouvelle âge d’or ou aura passé l’ARM à gauche.

]]>

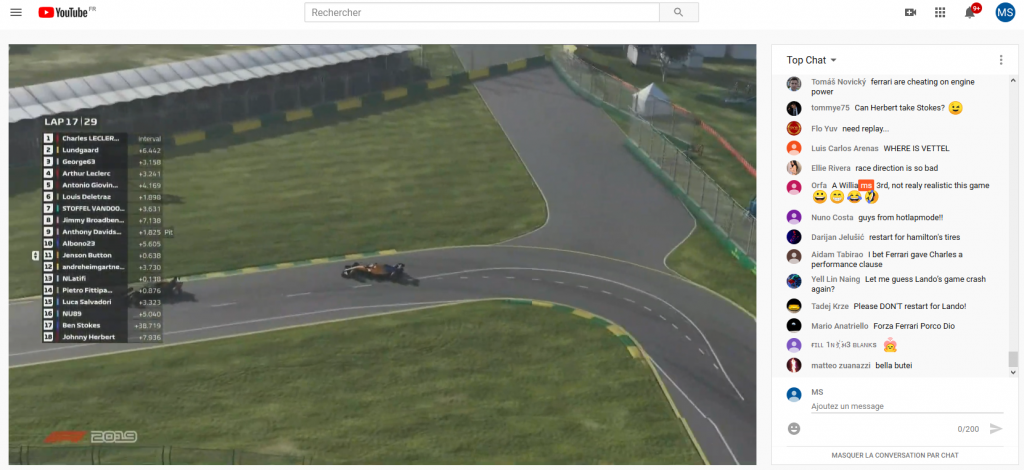

La course automobile est en effet un secteur qui se prête particulièrement à l’eSport, le contrôle d’une voiture de course virtuelle se faisant sensiblement de la même façon (un volant, deux ou trois pédales…) que celui d’une vraie voiture. Les compétitions automobiles virtuelles existent d’ailleurs depuis plusieurs années, mais elles restaient jusqu’à présent très confidentielles, suivies essentiellement par quelques fans de simulation, mais largement dédaignées par les amateurs de vraies courses automobiles.

Les choses pourraient changer en ce début d’année 2020, avec le « remplacement » des vraies courses par des championnats virtuels gérés par les organisateurs des vraies compétitions.

Du côté de la Formule 1, nous avons ainsi droit à la série F1 Virtual Grand Prix, des courses d’environ 45 minutes (la moitié d’un GP réel), courues sur les circuits de la F1, avec des F1 virtuelles aux performances égalisées, pour que tous les pilotes aient les mêmes chances. La FIA et Liberty Media ont malheureusement fait quelques choix qui gâchent un peu l’intérêt de ces courses. Tout d’abord, les courses sont organisées avec le seul jeu disposant d’une licence FIA, F1 2019. Un jeu très plaisant visuellement pour les spectateurs et qui peut être relativement réaliste, mais n’est pas au niveau des simulations les plus pointues.

Pire, pour permettre à des pilotes virtuels non habitués à cet exercice de participer aux courses, les organisateurs ont choisi de désactiver les dommages et d’autoriser les participants à utiliser l’ABS et l’anti-patinage… Des choix qui font que certains pilotes de F1 habitués du simracing ont préféré passer leur tour… Résultat, la grille de départ fait peine à voir, avec lors de la seconde course à peine 6 pilotes titulaires, totalisant seulement 6 saisons d’expérience, quelques réservistes et vétérans, dont Johnny Herbert, qui découvre les jeux de course, des sportifs d’autres disciplines, des journalistes et des « anonymes » issus du monde du simracing…

Outre Atlantique, les deux grands championnats, la NASCAR et l’IndyCar, ont opté pour une stratégie très différente de celle de la Formule 1. Les deux séries ont en effet opté pour l’organisation de courses virtuelles se voulant au plus près des courses réelles, avec un plateau constitué exclusivement des vrais pilotes de la discipline, s’affrontant sur la plateforme iRacing, réputée comme étant la simulation la plus réaliste du marché et très appréciée des pilotes professionnelles.

Si on néglige l’aspect visuel, les courses sont du coup assez proches des courses réelles, y compris sur l’aspect stratégique, comme on a pu le voir ce WE avec la belle victoire du français Simon Pageneaud sur l’anneau du Michigan grâce à une course à l’économie lui ayant permis d’éviter un arrêt au stand. Cette dimension stratégique est d’autant plus intéressante à suivre dans la mesure où certains flux permettent de suivre en direct les discussions entre le pilote et son ingénieur de course lui prodiguant des conseils sur la gestion de la course, chose impossible dans une course réelle, ces conversations étant tenues secrètes du fait du plus grand enjeu.

En plus de ces courses officielles, on observe ces dernières semaines une multiplication des évènements officieux, impliquant souvent quelques pilotes professionnels. Parmi elles, on notera en particulier The Race All Star Battle, qui oppose les meilleurs simracers à de nombreux pilotes réels sur le jeu rFactor 2, lui aussi réputé pour son réalisme. L’une des particularité de cette séroe est de faire varier les véhicules utilisés d’une manche à l’autre. Ainsi la dernière manche s’est courue en Norma M30 LMP3, tandis que la précédente mettait à l’honneur les monoplaces Tatuus PM-18 du championnat Pro Mazda. Cette série s’accompagne en prime d’un Legend Trophy, réservé aux pilotes professionnels de plus de 40 ans, qui se sont affrontés lors du dernier événement au volant de F1 McLaren M23 des années 70, après une première course sur des F1 Brabham BT44B de 1974.

L’ancien pilote de F1 français Jean-Eric Vergne organise pour sa part, via sa société Veloce eSport une série concurrente directe des F1 Virtual Grand Prix, la série « Not the *** GP », courue sur F1 2019 avec des caractéristiques quasi identiques à celle de la série officielle, aussi bien au niveau des caractéristiques des courses que des pilotes engagés, beaucoup participant aux deux séries.

Si le public est encore loin de celui des courses réelles, les F1 Virtual Grand Prix culminant à quelques centaines de milliers spectateurs lors des directs et quelques millions en différé, il est clair que la crise bénéfice grandement au monde des courses virtuelles en lui donnant une exposition sans précédent auprès du grand public. Dans certains pays, les diffuseurs des courses réelles ont même décidé de diffuser en direct les courses virtuelles. Reste maintenant à voir si ce format parviendra à s’enraciner suffisamment pour devenir une vraie alternative aux courses réelles sur le long terme, une fois la crise passée.

]]>

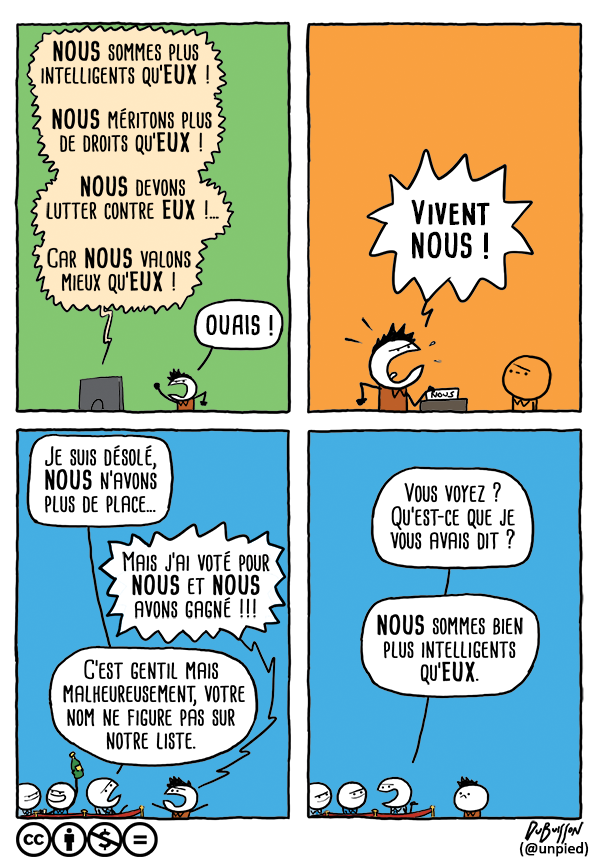

Mais depuis l’été dernier, ce flux RSS restait désespérément vide. Pourtant, je vois régulièrement des nouveaux strips passer sur les réseaux sociaux.

J’ai fini par en trouver la source : la rubrique Marc Dubuisson croque l’actu sur le site belge 7sur7. Bon j’ai pas été très malin sur ce coup, j’aurais pu le trouver plus vite, puisque tous les strips publiés dessus ont un en-tête 7sur7, en-tête qu’on trouvait déjà sur les derniers strips publiés sur Ab Absurdo… Bref…

Un problème tout de même : 7sur7 se contente de publier une suite d’images sur une page web, sans flux RSS. Pas pratique donc. J’ai vite fait essayé de convertir la page en RSS avec FetchRSS et RSS.app, mais dans les deux cas je me suis heurté au message d’acceptation des cookies de 7sur7 qui bloque le contenu.

C’est donc l’occasion de refaire un peu de web scraping. Et pour le coup, j’ai pas eu trop à ma fouler  La structure de la page est toute simple, une série de <div> avec une classe CSS article__component–picture facilitant leur identification, dans chacune un lien, et une image, avec en attribut le titre. Manque juste la date de publication, que je soupçonne d’être codée dans l’identifiant à 9 chiffres de chaque image, mais que je n’ai pas réussi à décoder. Pas grave, on peut s’en passer, même si c’est un peu moins propre. Il ne manque plus qu’un coup d’outils de dev Firefox pour trouver le bon cookie à envoyer avec la requête pour ne pas avoir l’écran d’acceptation des cookies, et voilà, en quelques lignes de Python on peut générer un joli flux RSS, parfaitement digéré par TT-RSS.

La structure de la page est toute simple, une série de <div> avec une classe CSS article__component–picture facilitant leur identification, dans chacune un lien, et une image, avec en attribut le titre. Manque juste la date de publication, que je soupçonne d’être codée dans l’identifiant à 9 chiffres de chaque image, mais que je n’ai pas réussi à décoder. Pas grave, on peut s’en passer, même si c’est un peu moins propre. Il ne manque plus qu’un coup d’outils de dev Firefox pour trouver le bon cookie à envoyer avec la requête pour ne pas avoir l’écran d’acceptation des cookies, et voilà, en quelques lignes de Python on peut générer un joli flux RSS, parfaitement digéré par TT-RSS.

Il n’y a plus qu’à croner tout ça pour mettre à jour régulièrement le flux

Il n’y a plus qu’à croner tout ça pour mettre à jour régulièrement le flux

Si vous aussi vous voulez profiter de ces strips dans votre lecteur RSS, vous pouvez récupérer le code de scraping sur mon Gist. Il nécessite Python 3 avec les modules BeautifulSoup4, lxml et requests.

]]>

Microsoft vient en effet de dévoiler le smartphone Surface Duo, son premier véritable smartphone « maison » (les précédents smartphones Microsoft étaient issus du rachat de Nokia), un appareil assez atypique, dont la sortie est prévue pour la fin de l’année 2020.

Plutôt que de continuer à investir à pertes dans son propre système mobile, Microsoft a préféré s’allier avec son ennemi d’hier : l’engin fonctionnera sous Android et bénéficiera de la licence Google, lui permettant donc d’embarquer le Play Store et les applications Google. Ou du moins, une partie des applications Google. Car si Microsoft a choisi de laisser la main à Google pour l’OS de ce smartphone, ce ne sera pas le cas pour les applications. Ainsi, on retrouvera de nombreuses applications et services Microsoft à la place de ceux de Google : Outlook pour les mails, OneDrive pour le stockage en ligne, Teams pour le travail collaboratif, le navigateur Edge, One Note, etc…

Autre particularité de ce smartphone, il se dote de deux écrans 5.6″ qui peuvent être utilisés simultanément en dépliant le téléphone ou individuellement en le laissant plié en deux. Si ce design semble être un net retard technologique par rapport aux appareils à écrans pliants lancés cette année par plusieurs constructeurs, il évitera de subir les défauts de jeunesse de ces écrans pliants…

Le géant semble croire très fort en ce concept bi-écran, puisqu’il a aussi dévoilé une tablette sur le même principe, la Surface Pro Neo, également prévue pour la fin de l’année prochaine. Cette dernière fonctionnera par contre avec un OS maison, baptisée Windows 10X, qui est une version de Windows 10 spécialement adapté à ce type d’appareils. À noter que cette tablette pourra se convertir en ordinateur portables presque classique en fixant un clavier sur une partie d’un des deux écrans, le reste de ce dernier devant alors une surface tactile pour manipuler le pointer.

S’il est difficile d’estimer aujourd’hui si ces produits seront bien accueillis par les clients (personnellement, je suis très circonspect…), il faut leur reconnaître au moins un mérite : Microsoft cherche à sortir des sentiers battus en proposant des produits innovants et originaux.

]]>

Dans des dimensions toujours identiques aux modèles précédents (85.6×56.5mm), le Raspberry Pi 4 embarque un nouveau SoC Broadcom, le BCM2711, qui troque les quatre cœurs ARM Cortex-A53 1.4 GHz pour quatre cœurs ARM Cortex-A72 à 1.5 GHz. Ne vous laissez pas tromper par la très faible augmentation de fréquence : le changement d’architecture promet des performances trois fois plus élevées.

Pour la première fois depuis le lancement du RPi original, le SoC du RPi 4 adopte également un nouveau GPU, le VideoCore VI. Outre des performances 3D accrues et le support d’OpenGL ES 3.0, ce nouveau circui gère le décodage matériel des codecs HEVC et H.264 en 4K60p, alors que l’ancienne version ses limitait au H.264 en 1080p30. La puissance graphique accrue permet également au RPi 4 de gérer deux écrans HDMI 4K 30 Hz ou un écran HDMI 4K 60 Hz.

Un autre défaut majeur des précédents RPi est également corrigé par cette version : le manque de mémoire. Si la version de base devra toujours se contenter de 1 Go de mémoire, la fondation a décidé pour la première fois de décliner la bête en deux autres capacités : 2 Go et 4 Go.

Côté connectivité, on retrouve un port Gigabit Ethernet, comme sur le RPi 3B+, mais celui-ci peut désormais réellement atteindre 1 Gbit/s, contre 300 Mbit/s sur l’ancien modèle. Le circuit Wi-Fi reste à la norme 802.11ac, tandis que le Bluetooth passe au 5.0. Autre évolution importante, deux des quatre ports USB sont désormais des ports USB 3.0, ce qui devrait donner un sérieux coup de boost aux performances du stockage externe. Le connecteur d’alimentation passe pour sa part à l’USB-C, pour permettre jusqu’à 15W et le stockage « interne » reste au format microSD. Les 17 connecteurs GPIO sont bien sûr toujours de la partie, tout comme la prise jack, le connecteur écran interne et le connecteur caméra.

Le monde n’étant pas parfait, on peut tout de même pointer deux petits défauts de cette nouvelle version. Tout d’abord, pour des question d’encombrement, les ports HDMI sont au format micro-HDMI, et nécessiteront donc un adaptateur pour la connexion d’un écran HDMI classique. Par ailleurs, l’emplacement du port Ethernet a été inversé avec celui de deux ports USB. Malgré la conservation du format habituel, ce nouveau RPi sera donc incompatible avec une bonne part des boîtiers conçues pour les versions précédente, alors que la compatibilité avait été assurée pour tous les modèles B depuis l’original, lancé en 2012.

Le RPi 4 est disponible dès à présent, au tarif officiel de 35$/45$/55$ pour la carte nue avec 1/2/4 Go de RAM et jusqu’à 120$ pour un kit complet, incluant un boîtier, un clavier, une souris, des câbles, une alimentation et une carte microSD de 32 Go.

]]>

Les moyens de la fondation /e/ étant relativement limités, il n’est bien entendu pas question qu’elle conçoive ses propres modèles de smartphones. Mais plutôt que d’opter à la place pour des smartphones génériques en marque blanche, la fondation va adopter une approche originale : les smartphones sous /e/ OS qu’elle va commercialiser sont tout simplement des smartphones reconditionnés et flashés avec /e/ OS à la place du système d’origine.

Quatre modèles seront proposés dans un premier temps, de 280 à 550€ : Samsung Galaxy S7, Samsung Galaxy S7 Edge, Samsung Galaxy S9 et Samsung Galaxy S9+.

/e/ promet des appareils dans un état très proche du neuf, avec une batterie tenant la route, déverrouillés et nettoyés. Il seront accompagnés d’une garantie d’un an.

Pour exploiter pleinement les smartphones sous /e/ OS, la fondation va également proposer des services en ligne respectueux de la vie privée : recherche, mail, stockage en ligne (5 Go gratuits), boutique d’applications… Le service mail, accompagné d’une extension du stockage jusqu’à 20 Gon est toutefois réservé pour l’instant à ceux qui ont contribué au financement de la fondation, sur Kickstarter, sur Indiegogo ou directement sur son site à hauteur d’au moins 99€.

Si vous êtes intéressé par l’achat d’un mobile reconditionné sous /e/ OS, vous pouvez vous manifester sur la page dédiée, sans engagement. Ceci permettra à la fondation d’affiner ses estimations de volumes et vous serrez notifié une fois l’appareil disponible.

Par exemple, une des versions de Libre Office proposées par cette société intègre une procédure de paiement par SMS pour valider l’installation.

Par exemple, une des versions de Libre Office proposées par cette société intègre une procédure de paiement par SMS pour valider l’installation.

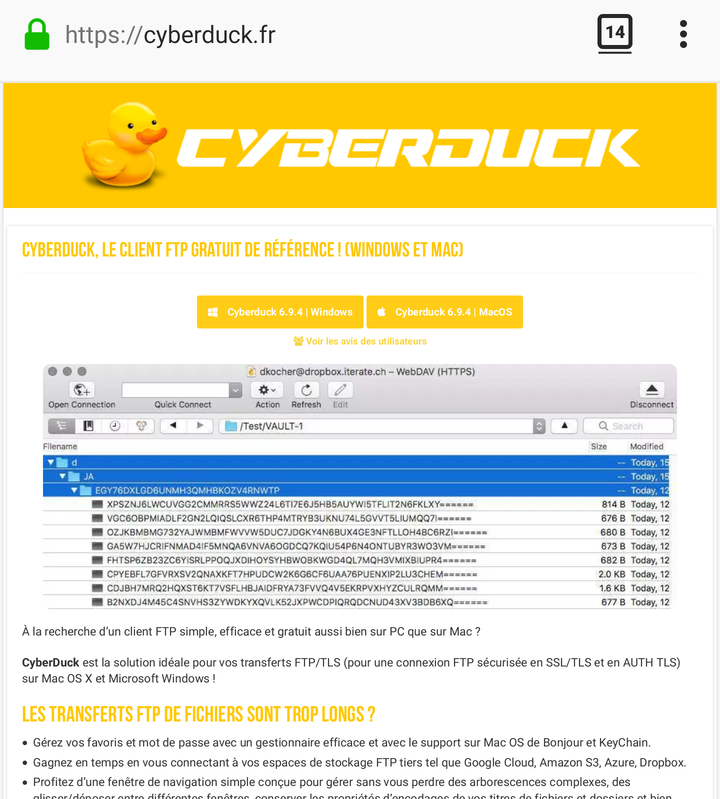

À ce jour, ce sont plus de 100 domaines qui sont hébergés sur le serveur loué par la société, qui cible des utilisateurs français, mais aussi italiens, espagnols, polonais, allemands… Parmi les logiciels victimes de ce phishing, on retrouve CyberDuck, PdfCreator, 7zip, AdBlock (proposer un bloqueur de pub infesté d’adwares, il fallait l’oser !), Gimp, Libre Office, Handbrake, Virtual Box, KeePass, TrueCrypt…

Le fait de cibler des logiciels libres n’est bien entendu pas un hasard, puisque ces logiciels sont plus faciles à repackager, mais aussi et surtout, parce que les recours légaux pour bloquer cette « attaque » sont beaucoup plus limités : repackager un logiciel libre, même en y ajoutant des logiciels malveillants, n’enfreint pas nécessairement la licence et les noms des logiciels libres sont souvent des noms non enregistrés comme marque commerciale. À ce propos, Data Access tente également d’enregistrer la marque TrueCrypt en son nom aux USA (rappelons que le logiciel TrueCrypt a été abandonné par son auteur, dans des conditions assez douteuses, ce qui fait que Data Access ne risque pas beaucoup de représailles en essayant de lui voler son nom…).

The Document Foundation, qui est en charge de Libre Office, est actuellement en discussion avec des avocats pour étudier les possibilités de recours légaux. En attendant, certains sites de la société sont déjà référencés dans certaines listes noires, ce qui permet leur blocage par des logiciels de sécurité ou des services de DNS publics, par exemple chez OpenDNS :

Il ne s’agit hélas pas d’une réelle nouveauté, cette façon de faire est courante depuis de nombreuses années, et même si les sites de Data Access sont bloqués, il ne faudra sans doute pas longtemps avant que d’autres sites du même acabit soient lancés par la société ou par d’autres personnes peu scrupuleuses.

Cette affaire est donc l’occasion de rappeler quelques bonnes pratiques pour limiter les risques lors du téléchargement de logiciels libres. Dans la mesure du possible, il faut toujours télécharger ces logiciels soit à partir du site officiel du projet, soit à partir de son dépôt de code sur GitHub, GitLab, SourceForge ou autre plateformes du genre. En effet, même les boutiques officielles comme l’App Store peuvent parfois être les hôtes de builds non officielles, plus ou moins modifiées et payantes.

Pour trouver l’adresse officielle du logiciel, vous pouvez utiliser des services comme Offurl, AlternativeTo ou tout simplement Wikipedia quand le logiciel est suffisamment connu pour y avoir sa page. Les fiches des logiciels sur les grandes plateformes de téléchargement commerciales (01net et cie) peuvent également parfois vous renseigner sur l’adresse du site officiel.

Merci à kwak-kwak qui nous a remonté cette information !

Ainsi, à l’occasion de la Game Developper Conference, Google a dévoilé les grandes lignes de Stadia, son futur service de jeux en streaming, pour lequel le géant de Mountain View semble voir très grand. Il faut dire qu’après être passé complètement à côté du marché des réseaux sociaux (Google+ fermera d’ailleurs ses portes dans quelques jours) et avoir raté l’explosion du streaming de films et séries, Google a intérêt à ne pas rater la prochaine vague s’il ne veut pas finir par être dépassé par de nouveaux acteurs.

Stadia promet donc une expérience de jeu digne des meilleurs PC d’aujourd’hui, grâce à des serveurs basés sur des puces conçues spécifiquement pour Google par AMD. Chaque joueur aura ainsi à sa disposition un CPU x86 à 2.7 GHz, un GPU développant 10.7 teraflops (soit un peu plus qu’une PS4 Pro et une Xbox One X réunies), et 16 Go de RAM ultra-rapide (484 Go/s), qui seront hébergés physiquement dans le datacenter Google le plus proche. Selon Google, cette configuration permettra de streamer des jeux en 4K à 60 images/seconde dans un premier temps, avant de passer plus tard à 8K et 120 images/seconde. Les jeux seront accessibles depuis n’importe quel ordinateur, smartphone ou tablette, à condition de disposer d’une connexion Internet rapide (25 Mbit/s pour du full HD, 30 pour du 4K). Google n’a par contre pas évoqué pour l’instant les tarifs et le catalogue de jeux, si ce n’est deux titres issus des franchises Doom et Assassin’s Creed. Il devrait être à priori relativement simple pour un éditeur d’adapter ses jeux à la plateforme Stadia, qui repose sur un système Linux et l’API Vulkan. Le service devrait être lancé avant la fin de l’année.

Point intéressant, les différents acteurs impliqués dans le streaming de jeux semblent opter pour des approches différentes, et il sera donc intéressant de voir qui aura fait le meilleur compromis, à même de satisfaire un maximum de joueurs.

Ainsi, si Google semble s’être orienté vers une solution haut de gamme, coûteuse en matériel et nécessitant une connexion Internet très performante, Microsoft, qui prépare un service de streaming de jeux Xbox One, semble s’orienter vers une solution plus accessible pour les petites connexions (à partir de 5 Mbit/s, comme le PS Now de Sony). Microsoft miserait aussi sur un partenariat avec Nintendo pour frapper un grand coup, en rendant les jeux Xbox One accessible sur la console Switch.

Le français Shadow, de son côté, a adopté une stratégie orientée infrastructure plutôt que plateforme : il fournit a ses abonnés un PC virtuel hebergé dans ses datacenters, et libre à l’utilisateur d’y installer les jeux qu’il souhaite. Une solution qui évite à Shadow d’avoir à négocier avec les éditeurs de jeux pour qu’ils amènent leurs titres sur sa plateforme, mais qui est par contre moins efficace sur le plan des performances, les jeux n’étant pas optimisés pour une utilisation en streaming.

Enfin, du côté de Valve, nous avons droit à une solution ne nécessitant aucun abonnement : plutôt que de faire tourner les jeux sur des serveurs, l’utilisateur fait tourner les jeux sur son propre PC connecté à Internet et les stream vers ses autres appareils. Initialement proposé uniquement au sein du réseau local, ce streaming est désormais possible aussi à distance vers les appareils Android, via la dernière beta de l’application Steam Link.

La solution de Steam sera sans doute la préférée des plus gros joueurs, qui continueront à privilégier autant que possible le jeu en local, et seront donc équipés d’un PC puissant, tandis que Microsoft et Google pourraient réussir à séduire des joueurs plus occasionnels, qui ne sont pas prêts à investir dans une bête de course, et sont donc actuellement souvent privés des derniers titres, trop gourmands pour leur configuration.

]]>

Après une décision similaire prise par Opera Software il y a quelques années, c’est donc un second navigateur majeur qui va se baser sur le moteur développé par Google, tout comme la plupart des petits navigateurs alternatifs disponibles aujourd’hui sur le marché. Ajoutons à cela le Safari d’Apple, qui utilise un moteur très proche (le moteur Blink de Chromium est un fork du moteur WebKit de Safari), et Firefox se retrouve désormais bien esseulé avec son moteur de rendu maison.

Si ce mouvement de concentration est plutôt une bonne chose du point de vue des développeurs web, qui auront moins de travail pour supporter pleinement tous les navigateurs, et pour les développeurs d’extensions, qui auront de moins en moins de spécificités de navigateur à gérer (d’autant plus qu’à ce niveau, Firefox a adopté le framework WebExtensions de Chromium pour faciliter les portages), cette concentration est par contre inquiétante pour le respect des standards du web.

En effet, avec un moteur de rendu dominant comme l’est Blink aujourd’hui, Google pourrait être tenté d’intégrer de plus en plus de fonctionnalités non standard, qui, une fois utilisées sur les sites web, contraindraient les utilisateurs à adopter un navigateur basé sur Blink. Une situation qu’on a déjà connu par le passé à l’époque où Internet Explorer dominait largement le marché alors qu’il était le moins respectueux des standards : certains sites étaient totalement inutilisables avec un navigateur standard, car totalement dépendants de fonctionnalités spécifiques à Internet Explorer.

De même, cette concentration pourrait devenir un frein à l’innovation, en réduisant la concurrence entre les navigateurs. Bon nombre de navigateurs « alternatifs » ne sont aujourd’hui guère plus que des clones de Chromium, avec quelques retouches visuelles minimes, sans que leurs développeurs ne se donnent la peine de chercher à développer des fonctionnalités innovantes.

Avec ses parts de marché en chute libre, Firefox risque donc de finir par se retrouver bien isolé.

[MàJ le 19/03/2019 à 23h10] Comme on pouvait le craindre, le passage à une base Chromium pour le navigateur de Microsoft isole toujours plus Firefox. Ainsi, la nouvelle version web de Skype ne fonctionne désormais plus que sous Chrome et Edge. Elle utilise pourtant des fonctionnalités multimédia tout a fait standard, mais les codecs supportés peuvent varier d’un navigateur à l’autre et Microsoft a fait le choix de se concentrer exclusivement sur la compatibilité avec ces deux navigateurs, pour des raisons de parts de marché.

[Article original : 12/12/2018 à 12h39]

]]>

Trois ans plus tard, rebelote, Free a débarqué sur le marché de l’ADSL, avec une offre unique, à la tarification agressive et offrant à tous les débits les plus élevés, plutôt que de faire comme la concurrence, qui proposait des offres à différents débits. Là encore, la simplicité du catalogue et la tarification agressive ont fait le succès de l’opérateur, malgré un matériel parfois récalcitrant et un SAV pas toujours à la hauteur. Le succès a ensuite été dopé par l’ajout régulier de nouveautés sans surcoût et en maintenant le principe de l’offre unique : téléphonie, TV, hausses de débit… En 2010, en lançant la Freebox Revolution, l’opérateur dérogea pour la première fois a ce principe. Si sur le papier l’offre Revolution était toujours au même prix, Free s’est mis à facturé la mise à disposition de la ligne, provoquant une hausse effective de l’abonnement de 6€ pour tous les abonnés en dégroupage total. Pour continuer à proposer une offre tout compris au tarif historique, l’ancienne Freebox était alors restée au catalogue. Pour la première fois, Free proposait deux offres.

Depuis, les choses ont encore évolué, avec l’intégration d’Alice dans Free, ajoutant au catalogue une offre supplémentaire en entrée de gamme. Et depuis quelques mois, l’opérateur proposait en outre des versions avec engagement de ses offres, proposées à un tarif plus faible pendant la première année, mais plus chères qu’auparavant au delà de cette première année… Trois offres, reposant sur trois Freebox différentes (et impossibles à « classer », la Freebox Mini 4K étant supérieure à la Révolution sur certains points, inférieure sur d’autres…), avec des bouquets TV différents… Bref, c’en était fini du catalogue simple et lisible…

Alors que le lancement d’une nouvelle version de la Freebox approchait, les rumeurs évoquaient régulièrement le lancement de deux offres, ce qui laissait espérer une rationalisation de la gamme, avec une base matérielle commune à toutes les offres. Hélas, la présentation en ce mardi 4 décembre confirme finalement que Free a bien changé et applique aujourd’hui toutes les recettes qu’il critiquait il y a quelques années chez ses concurrents.

Si ce sont bien deux nouvelles Freebox qui ont été lancées, il n’est par contre pas question de rationalisation pour l’instant : ce sont désormais 5 offres qui sont au catalogue de Free, un catalogue plus compliqué que jamais… On trouve ainsi 4 offres avec engagement d’un an, les anciennes Crystal, mini 4K et Révolution, à 25, 35 et 45€ par mois au delà de la première année, et la nouvelle One, qui vient s’insérer entre la mini 4K et la Révolution, avec un tarif de 40€ par mois (mais pendant la première année, elle est 10€ plus chère que la Révolution… allez comprendre…). La cinquième offre est sans engagement, à 50€ par mois. Mais l’abonnement n’inclus pas le boîtier TV, qui doit être acheté en plus, pour 480€ payables en 1, 4, 24 ou 48 fois sans frais…

Côté technique, la nouvelle offre One se distingue par le fait qu’elle repose sur un boîtier unique, faisant à la fois office de routeur et de boîtier TV. Et tant pis pour ceux dont la prise téléphone/fibre est loin de la TV. Elle accepte, comme les Freebox Révolution et mini, les connexions en fibre (1 Gbit/s descendant, 400 Mbit/s montant) ou en DSL et l’offre inclus les mêmes fonctionnalités que l’offre mini 4K, avec la téléphonie vers les fixes et l’international, le bouquet Freebox TV et Freebox Replay. Elle offre par contre en plus un abonnement Netflix Essentiel, ce qui permet de justifier le surcoût mensuel de 5€ par rapport à l’offre mini 4K, mais on se demande bien pourquoi avoir fait un matériel spécifique et contraignant pour cette offre, alors qu’une mini 4K remise au goût du jour (USB 3.0, WiFi ac, HDR) couplée avec une option Netflix aurait tout aussi bien fait l’affaire… L’abonnement Netflix offert est en outre limité à des flux SD, ce qui est fort dommage pour une box 4K HDR… Il en coutera 6€ de plus par mois pour bénéficier de Netflix en 4K.

Côté technique, la nouvelle offre One se distingue par le fait qu’elle repose sur un boîtier unique, faisant à la fois office de routeur et de boîtier TV. Et tant pis pour ceux dont la prise téléphone/fibre est loin de la TV. Elle accepte, comme les Freebox Révolution et mini, les connexions en fibre (1 Gbit/s descendant, 400 Mbit/s montant) ou en DSL et l’offre inclus les mêmes fonctionnalités que l’offre mini 4K, avec la téléphonie vers les fixes et l’international, le bouquet Freebox TV et Freebox Replay. Elle offre par contre en plus un abonnement Netflix Essentiel, ce qui permet de justifier le surcoût mensuel de 5€ par rapport à l’offre mini 4K, mais on se demande bien pourquoi avoir fait un matériel spécifique et contraignant pour cette offre, alors qu’une mini 4K remise au goût du jour (USB 3.0, WiFi ac, HDR) couplée avec une option Netflix aurait tout aussi bien fait l’affaire… L’abonnement Netflix offert est en outre limité à des flux SD, ce qui est fort dommage pour une box 4K HDR… Il en coutera 6€ de plus par mois pour bénéficier de Netflix en 4K.

L’offre Delta est pour sa part l’offre Freebox de tous les superlatifs. Côté connexion, on pourra compter soit sur une liaison fibre à 10 Gbit/s (bridée à 8 Gbit/s dans un premier temps) soit sur une liaison DSL + 4G pouvant atteindre 200 Mbit/s. Côté TV, on retrouve les deux bouquets Freebox TV et TV by Canal que proposait déjà la Freebox Revolution, auxquels s’ajoutent Netflix (toujours en version Essentiel…) et Canal VOD. Ajoutez à ça une véritable fonction NAS (jusqu’à 4 disques/20 To, avec 1 To livré d’origine), un boîtier TV faisant aussi office de barre de son (signée Devialet), d’enceinte sans-fil Bluetooth, d’assistant numérique (avec Amazon Alexa et l’assistant maison de Free), de hub domotique (compatible Somfy et Philips Hue) et même de hub de sécurité, avec différents capteurs à acheter sur la boutique en ligne de Free (caméra, détecteur de mouvement, détecteur d’ouverture…). Une offre qui est donc très complète, sans doute même un peu trop, menant à un tarif excessivement élevé par rapport à ce à quoi Free nous avait habitué.

Ce sont donc désormais 4 générations de Freebox qui cohabitent dans le catalogue de Free, avec une box dont la conception date désormais de plus de 12 ans pour l’entrée de gamme (la Freebox Crystal n’est qu’une Freebox V5 recarrossée) et des retards technologiques qui s’accumulent sur les offres de milieu de gamme. Il est difficile de dire si ces deux nouvelles Freebox permettront à Free de sortir de la spirale négative dans laquelle il se trouve actuellement, avec une baisse régulière du nombre d’abonnés, mais les offres associées donnent très nettement l’impression que les dirigeants de l’opérateur se concentrent désormais plus sur l’ARPU que sur le nombre d’abonnés… On remarquera d’ailleurs au passage que les tarifs « historiques » des anciennes offres ont disparu avec le lancement des nouvelles offres. Hier il était encore possible de s’abonner sans engagement et sans frais d’activation à une offre mini 4K ou Révolution pour 30 ou 40€ par mois, aujourd’hui il n’y a plus que les versions avec engagement et frais d’activation, à 35 et 45€ par mois !

]]>

Après avoir mis en place diverses solutions techniques pour faciliter le travail des constructeurs, notamment en isolant certains composants du systèmes via le fameux projet Trebble, le moins que l’on puisse dire c’est que les choses n’ont au final pas changé beaucoup… Il y a certes quelques constructeurs, comme Nokia, qui ont suivi la volonté de Google, ainsi que quelques smartphones chez divers constructeurs via le programme Android One, mais de manière générale, les mises à jour restent trop rares.

Après les solutions techniques et l’incitation, Google aurait donc décidé de passer à la vitesse supérieure en contraignant les constructeurs à assurer un minimum de suivi, via les contrats liant les constructeurs à Google. Même si la base du système Android est libre, les fabricants de smartphones dépendent de leurs contrats avec Google pour pouvoir vendre des appareils Android incluant les applications Google, et en particulier le Play Store et les Play Services, dont dépendent beaucoup d’applications. Perdre ce contrat serait donc une petite catastrophe d’un point de vue commercial.

Et c’est exactement la menace que ferait peser Google sur les constructeurs pour leur forcer la main sur les mises à jour. La firme de Mountain View imposerait en effet désormais dans les contrats que tous les appareils vendus à plus de 100 000 exemplaires bénéficient de mises à jour de sécurité pendant une durée minimale de deux ans, avec au minimum une mise à jour tous les 90 jours durant la première année. En cas de manquement injustifié, Google pourrait ne pas certifier les appareils ultérieurs du constructeur, leur fermant ainsi les portes des applications Google.

Dommage toutefois que cette règle ne concerne que les mises à jour de sécurité, et pas les mises à jour vers les nouvelles versions du système. Mais peut-être s’agira-t-il de la prochaine étape ?

]]>

Côté smartphones donc, ce sont les Pixel 3 et Pixel 3 XL qui viennent prendre la succession des Pixel 2 et Pixel 2 XL. Au menu, des écrans plus grands (5.5″ pour le petit, avec des bordures réduites et des coins arrondis, 6.3″ pour le grand, avec des cornes et une encoche sur le haut), un SoC plus performant (Snapdragon 845), un capteur photo en façade doté d’une plus grande ouverture (f/1.8), un second capteur photo 8MP en façade doté d’un objectif grand angle (97°, ouverture f/2.2) et le retour de la recharge sans-fil, en version rapide (10W). Tout ça dans des formats et designs quasiment inchangés par rapport à la génération précédente.

Les prix sont pour leur part également presque inchangés, ce qui veut donc dire que la note sera salée : 860€ pour le Pixel 3 et 960€ pour le Pixel 3 XL en version 64 Go, et 100€ de plus pour les 128 Go. Contrairement aux deux générations précédentes de Pixel, ces Pixel 3 seront disponible officiellement en France, avec une commercialisation début novembre. Qu’il est loin le temps des Nexus 4 à 300€ !

Alors qu’il avait cessé la commercialisation de ses tablettes Android sans les renouveler, Google a désormais de nouveau une tablette à son catalogue, la Pixel Slate. Elle se distingue nettement de ses ancêtres de la gamme Nexus au niveau du système d’exploitation, puisqu’elles adoptent la dernière version de Chrome OS, ce qui la rend bien plus intéressante, puisqu’elle peut du coup exécuter indifféremment des applications Chrome, des applications Android, mais aussi désormais des applications Linux (packages Debian), et ce en se manipulant comme une tablette ou comme un ordinateur portable via le clavier optionnel.

Mais là encore, la note est salée, puisqu’il en coûtera de 600$ pour le modèle de base (4 Go de RAM, 32 Go de stockage, processeur Intel Celeron) à 1600$ pour le modèle haut de gamme (16 Go de RAM, 256 Go de stockage, processeur Intel Core i7), auxquels il faudra ajouter 200$ pour le clavier et 100$ pour le stylet. Pour l’instant, elle ne sera pas commercialisée en France. Google n’a par contre pas officialisé la fonction permettant un dual-boot Chrome OS/Windows 10, malgré les rumeurs insistantes sur ce point depuis plusieurs mois.

Pour finir avec les produits hors de prix, les écouteurs Bluetooth Pixel Buds seront désormais disponibles en France, pour la modique somme de 180€…

Du côté des produits plus abordables, le Chromecast a droit à une mise à jour mineure, apportant principalement le support de la dernière génération de Wi-Fi (802.11ac) et la prise en charge des flux 1080p à 60 images par seconde (auparavant, 30 en 1080p, 60 en 720p). Le prix reste inchangé et le lancement en France aura lieu dans le courant de l’année prochaine.

Enfin, Google a présenté un tout nouveau produit dans sa gamme Google Home, le Google Home Hub, un concurrent direct de l’Amazon Echo Spot. Doté d’un écran tactile de 7″, il reprend toutes les fonctionnalités des appareils de la gamme Home (assistant, enceinte multi-room, contrôle domotique…), avec en plus la capacité d’afficher des informations, plutôt que de se limiter à la communication vocale.

]]>

Le ray tracing est une technique de rendu d’image radicalement différente de la technique classique (rasterisation). Alors que la rasterisation se contente de découper la scène 3D en un empilement de plans plus ou moins éloignés et de déterminer pour chaque pixel de l’image quel est le premier plan contenant un élément, le ray tracing consiste à simuler les rayons lumineux qui arrivent à l’œil de l’observateur (en pratique, le principe du retour inverse de la lumière est appliqué, et le rendu est réalisé en tirant les rayons à partir du point d’observation, ce qui permet d’éliminer tous les rayons qui ne convergent pas vers ce point).

Cette technique permet un rendu beaucoup plus réaliste, en particulier pour les jeux de lumière et les reflets, au prix d’une complexité bien supérieure des calculs, tant pour le rendu final de la scène que pour sa composition 3D, puisqu’il n’est plus question par exemple de décider d’ignorer un objet parce qu’il n’est pas au premier plan (il pourrait en effet apparaître dans un reflet…).

Pour pouvoir effectuer du ray tracing en temps réel, nVidia a introduit dans l’architecture Turing de nouvelles unités de calcul, les cœurs RT, qui sont spécialisées dans le traitement de certaines opérations et structures de données liées au ray tracing : arbres quaternaires, hiérarchies volumétriques, tests de collisions… Mais ceci n’est pas suffisant pour obtenir les performances de traitement requises et, en pratique, le ray tracing n’est utilisé que partiellement, pour affiner les réflexions et les ombres au sein d’une image dont le gros du rendu est effectué par rasterisation.

Cette technique hybride a toutefois l’inconvénient de laisser des « trous » dans l’image, à cause d’un manque de données. Pour palier ce problème, nVidia ajouté à Turing un second type d’unités de calcul, les cœurs Tensor.

Si vous suivez un peu l’actualité du secteur de l’IA, ce terme n’est pas nouveau pour vous. Les tenseurs sont des outils mathématiques massivement utilisés dans l’apprentissage profond (deep learning), car ils permettent d’exécuter très rapidement des modèles déjà entrainés en simulant le comportement des neurones. Depuis quelques années déjà, on observe l’arrivée de circuits spécialisés dans les calculs de tenseurs (TPU, Tensor processing unit) pour le secteur de l’intelligence artificielle, qui a besoin de traitements très rapides, quitte à sacrifier les précision.

nVidia a donc mis à profit le deep learning sur de gros calculateurs pour mettre au point un modèle d’IA qui va remplir les trous dans le rendu en s’exécutant sur les cœurs Tensor des GeForce RTX, évitant ainsi de mobiliser les ressources des shaders.

Si les premières démonstration de jeux utilisant le ray tracing sont impressionnantes en terme de rendu de certains détail, il faudra toutefois sans doute encore beaucoup de temps avant que ces nouvelles techniques de rendu soient largement adoptées, les performances de cette première génération de cartes étant encore un peu faiblardes, limitant du coup la définition des rendus.

Pire, nVidia fait payer très cher cette nouveauté (de 640€ pour une RTX 2070 à près de 1300€ pour une RTX 2080), sur des cartes graphiques qui en dehors du ray tracing n’offrent pas beaucoup de nouveautés par rapport à la génération précédente, tout en n’étant pas non plus beaucoup plus rapides : sur le papier, le fillrate de la RTX 2080 est quasi identique à celui de la GTX 1080, tandis que la puissance de ses shaders n’augmente que d’une dizaine de pourcent. nVidia promet toutefois des performances jusqu’à doublées dans les jeux existants, grâce à un nouveau mode d’anti-aliasing, utilisant lui aussi une IA pour déterminer au mieux les éléments de l’image ayant besoin d’un lissage.

En attendant la démocratisation du ray tracing dans les jeux, les nouveaux GPU nVidia feront donc bien plus la joie des centres de calcul que celle des joueurs.

]]>

SpiderOak, qui habituellement propose uniquement des offres limitées en volume (et 150 Go à 5 To pour 60 à 280$ par an), propose jusqu’au 8 août à minuit CST (soit le 9 août à 7h CET) une offre promotionnelle plutôt agressive : volume et nombre d’appareils illimités pour 180$ par an, à vie.

Outre la sauvegarde, le service permet également la synchronisation de dossiers entre plusieurs machines et le partage de dossiers avec des tiers. Le logiciel client est compatible Mac, Linux et Windows et un client limité à la récupération de données est disponible sous iOS et Android.

S’il n’est pas le service le plus performant du marché, le service One Backup de SpiderOak se distingue de la concurrence par l’accent mis sur la protection des données, SpiderOak ayant depuis toujours adopté une politique de chiffrement « no knowledge » : SpiderOak n’a jamais accès à la clé de chiffrement des données. Cette politique lui avait d’ailleurs valu les faveurs d’Edward Snowden, qui avait recommandé aux gens de l’adopter à la place de Dropbox.

Si l’offre vous intéresse, suivez simplement les instructions sur le site de SpiderOak.

[MàJ] L’offre est finalement valable jusqu’au 15 août à minuit (16 août à 7h en France).

Partant de ce constat, la plateforme collaborative Terms of Service; Didn’t Read (ToS;DR) entend aider les internautes à comprendre les implications de ces contrats qu’ils valident sans les avoir lus, en proposant un résumé de ces conditions, ainsi qu’une note, allant de A pour les plateformes dont les conditions d’utilisations sont les plus justes envers l’utilisateur et qui n’exploitent pas à outrance les données de l’utilisateur, jusqu’à E pour les plateformes dont les conditions d’utilisations soulèvent des problèmes importants.

Le classement se base sur le travail de la communauté, qui se charge d’extraire les points les plus importants des contrats, d’en proposer un résumé et de les noter individuellement. La synthèse de ces notes individuelles donnera la note globale de la plateforme, à condition d’avoir suffisamment de données pour que la note soit significative.

À titre d’exemple, les moteurs de recherche alternatifs Qwant et DuckDuckGo ont tous deux reçus la note maximale, tandis que Google doit pour sa part se contenter d’un C, à cause de la collecte de certaines données (signature des appareils), de la possibilité d’arrêter ou de limiter le service à tout moment et en raison du partage de certaines données avec des tiers. Sa plateforme YouTube fait même encore moins bien, avec seulement une note de D.

La route sera toutefois encore longue pour parvenir à une base de notation exhaustive, les plateformes ayant déjà une note sont encore assez peu nombreuses (une quinzaine), tandis que bon nombre de plateformes très populaires (Facebook, Twitter, Apple, GitLab, Disqus, Evernote, Steam, Dropbox, WordPress.com, Microsoft…) n’ont pas encore été notées.

Si vous être motivés, n’hésitez pas à participer !

]]>

Un montant qui double quasiment le record précédent, déjà « établi » par Google il y a un an, avec 2.43 milliards d’euros pour abus de position dominante dans le secteur des comparateurs de prix. Ce montant n’est toutefois pas le maximum permis par la réglementation européenne, qui autorise une amende allant jusqu’à 10% du chiffre affaire annuel, la Commission s’étant ici contentée de « seulement » 5%.

Pour justifier cette amende, la Commission indique trois abus de Google. En premier lieu, c’est l’obligation d’installer diverses applications Google, dont Chrome et Search, lors de l’installation de Google Play qui a été visée. Google Play est en effet une suite logicielle quasiment indispensable pour réussir à vendre un appareil Android, et Google se sert de cette situation pour imposer la présence de bon nombre de ses services.

En second lieu, la Commission reproche à Google d’avoir payé certains constructeurs et opérateurs mobiles pour s’assurer que Google Search soit la seule application de recherche préinstallée sur les smartphones.

Enfin, le troisième point est le fait que Google refuse de certifier les appareils Android d’un constructeur dès lors que ce dernier produit également des appareils fonctionnant sur des variantes d’Android (comme les Kindle Fire d’Amazon par exemple). Sans cette certification, les appareils Android ne peuvent pas être livrés avec Google Play, ce qui rend leur commercialisation bien plus difficile.

Cette condamnation va sans doute obliger Google a revoir en profondeur le modèle économique d’Android, d’autant qu’elle pourrait faire des émules dans d’autres zones géographiques. Ainsi, bien que le président américain ait vertement critiqué la décision sur Twitter, elle a reçu le soutien de plusieurs élus démocrates, et la FTC a indiqué s’intéresser de près au dossier. Parmi les évolutions possible de ce modèle économiques, Google a notamment évoqué la possibilité de vendre des licences Google Play, afin de rentabiliser directement son développement, sans avoir à compter sur les retombées indirectes obtenues via la promotion des autres services Google.

Notons également qu’une autre amende pourrait venir s’ajouter aux deux précédentes, Google étant toujours sous le coup d’une troisième enquête de la Commission Européenne, concernant cette fois le marché de la publicité en ligne, dominé par la régie Google AdSense.

]]>

En effet, même si les micro-architectures modernes n’ont plus grand chose à voir avec celle du 8086, les processeurs Intel et AMD d’aujourd’hui restent compatibles avec le jeu d’instruction du 8086, et peuvent donc en théorie exécuter sans modification n’importe quel logiciel écrit pour ce vénérable ancêtre. C’est d’ailleurs pour cela que ces processeurs sont aujourd’hui communément appelés x86, car ils sont les descendants directs de la lignée 8086, 80186, 80286, 80386, 80486…

Pour fêter cet anniversaire, Intel a décidé de « ressortir » le 8086, en lançant un nouveau processeur en édition limitée : le Core i7-8086K. Commercialisé pour 425$, ce processeur Coffee Lake se situera juste au dessus du Core i7-8700K (vendu pour sa part 359$), dont il reprend presque toutes les caractéristiques techniques : 6 cœurs, 12 threads, 1.5 Mo de cache L2, 12 Mo de cache L3, un IGP UHD Graphics 630, le tout prenant place sur un socket 1151.

La différence entre les deux modèles se situe sur la fréquence de fonctionnement, qui augmente de 300 MHz, soit une fréquence de base de 4 GHz pouvant monter jusqu’à 4.6 GHz sur 6 cœurs et 5 GHz sur un seul cœur. Il s’agit ainsi du premier processeur Intel commercialisé officiellement à une fréquence de 5 GHz.

]]>

Il y a quelques semaines, Valve a annoncé le lancement d’une application Steam Link permettant de diffuser à destination d’un appareil sous Android, iOS ou tvOS.

Si la version beta de l’application est d’ores et déjà disponible pour Android, il en sera hélas autrement pour la version destinée aux OS d’Apple. Dans un communiqué de presse, Valve indique en effet qu’Apple a rejeté la dernière version de l’application, au motif qu’elle entrerait en conflit avec l’activité commerciale (« business conflicts ») d’Apple. Une décision bien entendu contestée par Valve, qui a tenté de défendre son cas en expliquant à Apple que son application n’est rien d’autre qu’un système de « bureau à distance » comme il en existe déjà sur l’App Store (Microsoft RDP, VNC Viewer…), mais son appel a été rejeté.

Outre le fait qu’on se demande avec quel produit Apple cette application peut bien entrer en conflit (Apple envisagerait-elle de lancer son propre service de streaming de jeux vidéo ?), cette affaire illustre encore une fois les difficultés que peuvent rencontrer les développeurs face à une logique de sélection peu prévisible et parfois à la limite de l’arbitraire. Valve précise d’ailleurs qu’une première version de l’application avait été acceptée le 7 mai, avant qu’Apple ne change d’avis et profite d’une mise à jour corrective publiée deux jours plus tard pour rejeter l’application.

La décision semble d’autant plus arbitraire qu’il existe depuis plus de trois ans une autre application destinée à diffuser sur iOS des jeux exécutés sur un PC, KinoConsole. Difficile donc de justifier le rejet de l’application de Valve.

En attendant un nouveau revirement, il sera donc plus facile pour les utilisateurs de Mac de diffuser leurs jeux Steam vers des appareils Android que vers des appareils iOS…

La première annonce concerne la disponibilité de la version Developer Preview du futur Android P (Android 9). C’était une tradition bien huilée, chaque année la Google I/O s’accompagnait du lancement d’une version DP disponible pour les appareils Google datant de moins de deux ou trois ans. Cette année, pour la première fois, la DP sera aussi disponible chez plusieurs autres constructeurs. Ainsi, ce sont une dizaine de modèles qui sont éligibles, chez sept constructeurs : Essential Phone, les quatre Google Pixel, Nokia 7 Plus, Oppo R15 Pro, Sony Xperia XZ2, Vivo X21 et X21UD, Xiaomi Mi Mix 2S. On notera tout de même l’absence remarquée de Samsung et LG ainsi que de modèles d’entrée et de milieu de gamme.

L’arrivée des version DP sur un plus grand nombre de modèles est sans doute la conséquence directe de la mise en place du projet Treble, qui, en revoyant l’architecture du système pour mieux séparer les couches basses des surcouches constructeurs, visait à faciliter la mise à jour du système sur les appareils équipés d’une surcouche constructeur.

La seconde annonce vise un point moins visible, mais tout aussi important, si ce n’est plus : les mises à jour de sécurité. Depuis quelques années déjà, Google publie chaque mois une mise à jour d’Android dédiée aux correctifs de sécurité, indépendamment du cycle des versions du système. Mais comme pour les nouvelles versions du système, les constructeurs d’appareils Android trainent des pieds lorsqu’il s’agit de pousser ces mises à jour de sécurité vers leurs clients. Google envisage donc de sortir l’artillerie lourde, en imposant contractuellement aux constructeurs la diffusion de ces mises à jour de sécurité.

En effet, même si le système Android de base est libre et peut donc être utilisé par n’importe quel constructeur sans le moindre accord avec Google, la plupart des constructeurs veulent livrer leurs produits avec les « Google Apps », un ensemble d’applications (dont le Play Store) sans lesquelles les appareils Android sont bien peu séduisant pour les consommateurs. Ces applications étant propriétaire, leur livraison avec les appareils Android nécessite un accord entre le constructeur et Google. Et c’est donc via cet accord que Google voudrait imposer la diffusion des mises à jour de sécurité.

Espérons que ces mesures permettront enfin d’espérer un suivi digne des mises à jour digne de nom sur les appareils Android, au moins sur les modèles haut de gamme.

]]>