I første halvdel af 1900-tallet udvikledes grundlaget for kunstig intelligens og informationsteknologi generelt i form af særlige sammenkoblinger mellem teorier om tænkning, logik, automatik, formelle sprog og matematik. Man nåede frem til en afklaring af, hvad det præcis vil sige, at et problem er beregneligt efter en mekanisk procedure, bl.a. gennem Alan M. Turings model fra 1936 af en abstrakt maskine, Turingmaskinen, der kunne udføre enhver udførbar beregning. Alfred Tarski viste, hvordan man kunne konstruere en matematisk semantik for formelle sprog. Kurt Gödel påviste sammenhængen mellem bevis, sandhed og logisk følge. Claude Shannon viste i 1938, at elektriske kredsløb kan implementere alle operationer i boolesk logik, og efter 1945 udvikledes von Neumann-computeren (opkaldt efter matematikeren John von Neumann), den moderne serielle computer.

Alt dette var forudsætninger for den bro, man forestillede sig, AI skulle bygge mellem det tankemæssige, man ellers havde opfattet som noget rent immaterielt, og det maskinelle, som ofte ansås for noget rent fysisk og åndløst. Ligesom konstruktionen af regnemaskiner lignede et eksistensbevis på, at en bestemt sektion af den menneskelige tænkning, nemlig talbehandling, kunne mekaniseres, så kunne man forestille sig, at intelligent tænkning dybest set havde form af en indre og ubevidst kalkule eller et "tankesprog", som kunne opdages, og som indeholdt en nøje defineret grammatik af rent syntaktiske regler, herunder de logiske regler for gyldige ræsonnementer. Tænkte mennesket på basis af et sådant logisk-matematisk opbygget tankesprog, og lod dette sig finde, kunne man implementere det i en maskine, så dens processer kunne behandle de repræsenterede tanker ved hjælp af dette sprogs syntaktiske regler.

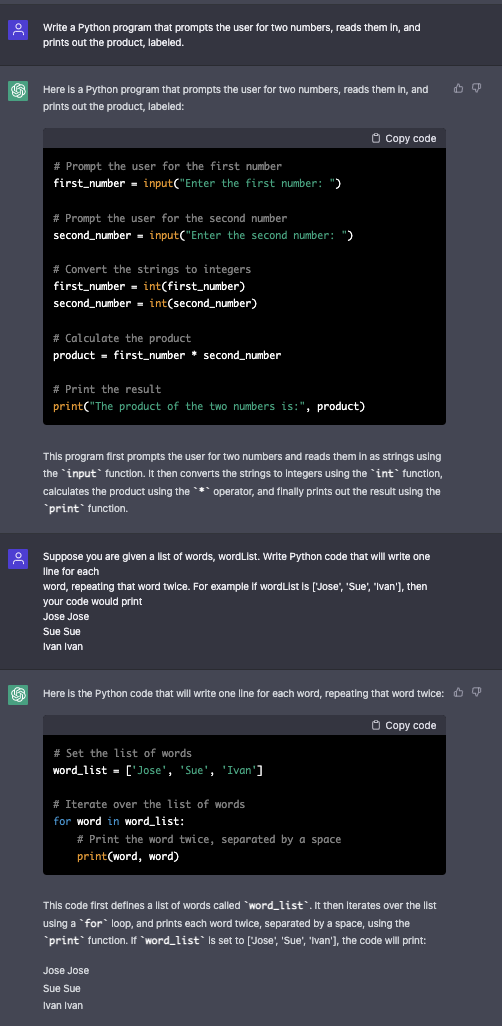

Som et egentligt forskningsfelt, hvor man begyndte at præcisere denne formodning i forsøget på at konstruere intelligente systemer, begyndte AI først omkring 1955. Tre faktorer er helt essentielle for idéen om tænkning som en art indre formelt sprog:

1) De enkelte tankeelementer antages at være ordnet i en kombinatorisk syntaktisk struktur (en grammatik). Det vil sige, at den består af veldefinerede arrangementer; elementerne svarer til ord, arrangementerne til sætninger, men det antages ikke, at de ligner kendte ord eller sætninger.

2) Indholdet af tankeelementerne, det, de betyder, er systematisk bestemt ved deres sammensætning. Betydningen er kompositionel, på samme måde som betydningen af en sætning i store træk kan ses som fastlagt af dens grammatik og betydningen af de enkelte ord.

3) Endelig er tankerækkerne, den intelligente proces, specificeret alene af syntaktisk fastlagte regler; dvs. de kan udføres af mekanismer, der kun styres af formel syntaks. Semantikken, dvs. indholdet eller meningen, antages at følge med af sig selv. Her ligger analogien med bevisteori: Et arguments formelle gyldighed afgøres alene af, om det følger formelt gyldige slutningsregler. Hvis dette er opfyldt, vil sandheden af de oprindelige præmisser bevares i nye, afledte sætninger.

I sidste halvdel af 1950'erne udviklede man på basis af disse idéer de første programmer, der kunne spille skak eller bevise matematiske teoremer, dvs. maskiner, der løste problemer ikke blot ved beregning, men ved logisk deduktion. Blandt de forskere, der fra begyndelsen tegnede AI, var trioen Allen Newell (1927-92), J. Cliff Shaw (1922-91) og Herbert A. Simon, som på den første AI-konference i 1956 præsenterede et logikprogram, der skulle løse problemer ved at lede i et søgerum af mulige løsninger, hjulpet af visse tommelfingerregler, samt John McCarty (1927-2011) og Marwin Minsky (1927-2016), der sammen grundlagde AI-Laboratoriet ved MIT, USA, i 1958.

Det blev fra begyndelsen debatteret, hvorvidt det, de tidlige AI-programmer kunne udføre, virkelig var "intelligent". Alan M. Turing foreslog allerede i 1950 Turingtesten, oprindeligt under navnet efterligningsspillet (the imitation game), som operationelt kriterium for, om en maskine kunne opføre sig intelligent: Maskinen består testen, hvis en person, som må udspørge maskinen og et andet menneske om hvad som helst, ikke kan afgøre om svaret kommer fra maskinen eller mennesket. Der var bred enighed blandt forskere, inklusiv Turing, om at Turingtesten ikke var et brugbart kriterium for, om AI-programmer faktisk var intelligente eller kunne tænke.

Moderne sprogmodeller som GPT kommer ofte tæt på at kunne bestå Turingtesten.

Kommentarer

Kommentarer til artiklen bliver synlige for alle. Undlad at skrive følsomme oplysninger, for eksempel sundhedsoplysninger. Fagansvarlig eller redaktør svarer, når de kan.

Du skal være logget ind for at kommentere.